import tensorflow as tf

import numpy as np

# create data

x_data = np.random.rand(100).astype(np.float32)

y_data = x_data*0.1 + 0.3

Weights = tf.Variable(tf.random_uniform([1], -1.0, 1.0))

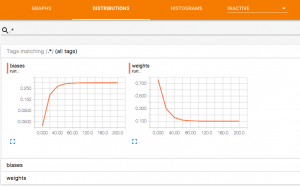

tf.summary.histogram(‘weights’,Weights)

biases = tf.Variable(tf.zeros([1]))

tf.summary.histogram(‘biases’,biases)

y = Weights*x_data + biases

loss = tf.reduce_mean(tf.square(y-y_data))

optimizer = tf.train.GradientDescentOptimizer(0.5)

train = optimizer.minimize(loss)

init = tf.global_variables_initializer()

sess = tf.Session()

merged = tf.summary.merge_all()

writer = tf.summary.FileWriter(“logs/”,sess.graph)

sess.run(init)

for step in range(201):

sess.run(train)

if step % 20 == 0:

rs = sess.run(merged)

writer.add_summary(rs,step)

# print(step, sess.run(Weights), sess.run(biases), sess.run(loss))

可視化したい情報をtf.summary.histogram(‘グラフィック名’,変数名)に追加する。

このファイルのpathは~/Document/tensorflow/tensorboard.py、そして、実行の結果は~/Document/tensorflow/logsフォルダーに保存する。

次はターミナルを起動して

$cd ~/Document/tensorflow

$tensorboard –logdir logs

表示するurlをブラウザにコピー貼り付けて完了

*urlは127.0.0.1:6006にしても大丈夫だと思う